Os Perigos Ocultos das Ferramentas de IA!

O que você precisa saber sobre as novas "Nano Tools for Leaders"!

Descubra como a tecnologia pode ser uma faca de dois gumes!

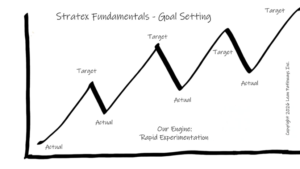

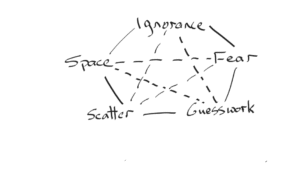

Prepare-se, porque as novas ferramentas de IA prometem revolucionar o que pensávamos conhecer sobre liderança! Essas “Nano Tools for Leaders” podem parecer a solução mágica para ampliar resultados e produtividade, mas a verdade é que elas também trazem um vendaval de riscos ocultos! O governo atual finge que tudo está sob controle, mas a realidade é bem diferente: líderes estão sob pressão e a confiança no uso desses sistemas é mais frágil do que um cristal!

Quando se trata de inteligência artificial nas organizações, a pressão é fortíssima! Os líderes têm de garantir que essas tecnologias sejam não só eficazes, mas também responsáveis! Um pequeno erro e… boom! Multas, danos à reputação e a confiança evaporada! É chocante como muitos delegam essa responsabilidade a fórmulas mágicas, sem pensar que a responsabilidade deve estar integrada desde o início, e não ser uma solução improvisada após o problema.

E o que devemos fazer para evitar essa tragédia anunciada? Vamos analisar alguns passos cruciais que todo líder deve seguir se não quiser ver sua organização afundar na lama da desconfiança!

Passo a Passo para a Sobrevivência!

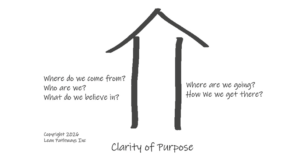

1. Defina Limites Claros

É fundamental que cada sistema de IA tenha um propósito claramente documentado! Isso inclui o que deve e o que não deve ser feito! Falhar nisso pode ser desastroso, como o uso impróprio de reconhecimento facial em contextos delicados. É hora de alinhar essas utilizações com os valores éticos da empresa – ou o caos estará à espreita!

2. Forme um Conselho de Governança

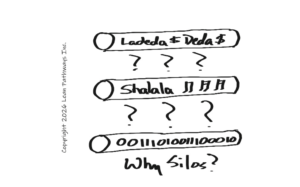

Chega de decisões unilaterais! Um conselho precisa ser formado, com líderes de diversas áreas, incluindo legal, ética e operações. Estamos falando de uma estrutura robusta para revisar casos de alto impacto e atualizar as regras quando as tecnologias mudam! No mundo atual, não ter essa segurança é um convite ao desastre!

3. Responsabilidade Humana é Vital!

É preciso designar pessoas que realmente respondam pelos sistemas de IA! Não basta dar uma olhadinha nos números e achar que tudo está certo! Essa equipe precisa ter autoridade para agir, levantar questões e resolver problemas em tempo real! Sem isso, a desconfiança reinará absoluta!

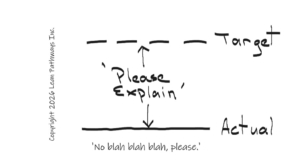

4. Exigência de Explicabilidade

Estamos em tempos de transparência! Se o seu modelo de IA não pode ser explicado em termos simples, então ele pode ser perigoso! Quando as decisões não são claras, a confiança se desmorona. A comunicação é chave – conte ao mundo o que seu sistema faz e como ele funciona!

5. Teste para Evitar Bias e Dano

Nada de surpresas desagradáveis! As saídas dos sistemas de IA devem ser auditadas frequentemente para evitar preconceitos e discriminações! Simulações de situações extremas devem ser realizadas para garantir que a segurança e a ética sejam mantidas durante todo o ciclo de desenvolvimento!

6. Documentação e Comunicação

Surpreenda-se: manter registros claros de como a IA foi treinada é essencial! Compartilhe informações relevantes com todos os envolvidos, a fim de fomentar a confiança! E lembre-se: a avaliação não termina na implementação; é preciso continuar monitorando essa tecnologia!

Exemplos de Gigantes!

JP Morgan, Salesforce e Mastercard já estão na corrida da responsabilidade ao desenvolver suas políticas de IA! Eles investem em equipes robustas e conselhos para garantir que suas práticas gerenciais sejam transparentes e éticas! Enquanto isso, nós cidadãos comuns aguardamos ansiosamente por práticas semelhantes em todos os setores!

O que está em jogo é muito maior do que uma simples inovação! É a nossa confiança, a integridade das instituições e o futuro que está na linha de fogo! O governo precisa agir, mas, por enquanto, somos nós que estamos na linha de frente da batalha!